Z rozwojem sztucznej inteligencji (AI) i narzędzi takich jak modele dużych języków (LLM), termin prompt engineering stał się kluczowy w dziedzinie interakcji z AI. W skrócie, prompt to polecenie lub pytanie w języku naturalnym, które opisuje zadanie, jakie użytkownik chce zlecić modelowi AI. Dzięki odpowiedniemu zaprojektowaniu promptu, AI jest w stanie wygenerować wyniki odpowiadające na potrzeby użytkownika.

Z artykułu dowiesz się:

- Czym jest prompt engineering? – Poznasz definicję prompt engineeringu i jego znaczenie w pracy z modelami AI.

- Jak pisać skuteczne prompty? – Dowiesz się, jak tworzyć precyzyjne i trafne prompty, które zapewniają dobre wyniki.

- Zaawansowane techniki promptowania – Poznasz techniki, takie jak In-Context Learning i Chain-of-Thought, które pomagają w rozwiązywaniu trudniejszych zadań.

- Zasady etyczne w prompt engineeringu – Zrozumiesz, jak unikać błędów i dyskryminacji oraz jak zapewnić dokładność i transparentność odpowiedzi.

- Kluczowe umiejętności w pracy z AI – Dowiesz się, jakie kompetencje pomagają w tworzeniu skutecznych promptów.

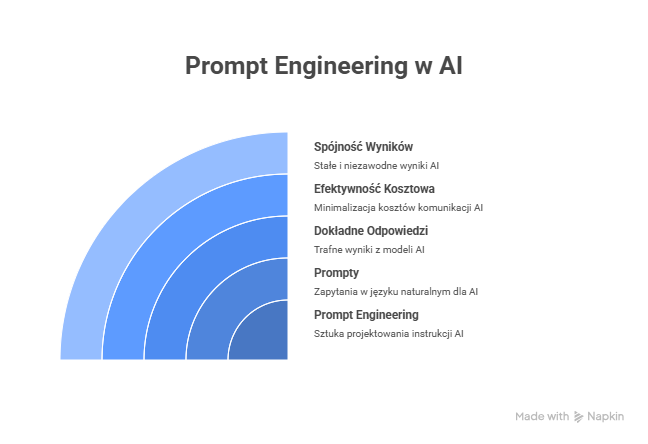

Prompt engineering to proces tworzenia i optymalizacji tych promptów, aby zapewnić, że otrzymywane odpowiedzi będą jak najbardziej trafne i precyzyjne. Zyskanie biegłości w prompt engineeringu to umiejętność efektywnej komunikacji z modelem AI. Istnieje wiele technik, które pozwalają tworzyć prompty bardziej wydajne, szybciej działające i bardziej skalowalne. Można to porównać do wczesnych prób programowania w języku naturalnym, gdzie kluczowe staje się to, jak formułujemy zapytania.

Co tak naprawdę kryje się za terminem „Prompt Engineering”?

Prompt engineering to proces projektowania i strukturyzowania instrukcji, które mają na celu uzyskanie lepszych i bardziej trafnych wyników od generatywnego modelu AI. W praktyce oznacza to tworzenie promptów – czyli zapytań lub poleceń w języku naturalnym – które są precyzyjnie dostosowane do potrzeb użytkownika. Dzięki umiejętnemu podejściu do prompt engineeringu, możliwe jest uzyskiwanie bardziej dokładnych odpowiedzi oraz minimalizowanie kosztów związanych z nieefektywną komunikacją z modelem.

W kontekście produkcji i biznesu, dobrze zaprojektowane prompty są kluczowe, by zapewnić spójność w wynikach i uniknąć błędów, które mogą wynikać z nieprecyzyjnych lub źle sformułowanych zapytań. Odpowiednia wiedza z zakresu prompt engineeringu jest więc nieoceniona, ponieważ umożliwia zwiększenie efektywności pracy z narzędziami AI, które stają się coraz bardziej powszechne w różnych branżach.

Jakie wyzwania wiążą się z prompt engineeringiem w praktyce?

Chociaż narzędzia AI, takie jak ChatGPT, charakteryzują się niskim progiem wejścia, a każdy może spróbować z nich korzystać, to praca z nimi na wyższym poziomie wiąże się z pewnymi wyzwaniami. Modele LLM (Large Language Models) są niedeterministyczne, co oznacza, że ten sam prompt może generować różne odpowiedzi za każdym razem. To może być zarówno zaletą, jak i wadą, zależnie od kontekstu i potrzeb użytkownika.

Zaawansowany prompt engineering wymaga traktowania modelu AI jako narzędzia w ramach większego systemu, w którym interakcja z AI musi być ściśle zaplanowana. Warto dodać, że firmy odpowiedzialne za tworzenie takich narzędzi często nie udostępniają szczegółowych instrukcji dotyczących ich używania. W związku z tym, użytkownicy AI muszą polegać na własnym doświadczeniu i wiedzy, aby odkrywać najlepsze praktyki i techniki, które pozwalają na efektywne tworzenie promptów.

Zatem rola prompt engineer staje się coraz bardziej istotna, a jego praca nabiera charakteru eksperckiego, który pozwala na maksymalne wykorzystanie potencjału sztucznej inteligencji. Kto opanuje sztukę prompt engineeringu, będzie mógł w pełni wykorzystać możliwości narzędzi AI i zyskać przewagę na rynku pracy.

Fundamenty Dobrego Promptu: Podstawowe Praktyki Inżynierskie

Jak zapewnić jasność i kontekst w swoim promptcie?

Podstawą skutecznego prompt engineeringu jest dostarczenie jasnego i szczegółowego kontekstu, który pozwala modelowi AI wykonać zadanie z wysoką precyzją. Kontekst jest kluczowy, ponieważ im więcej szczegółów dostarczymy, tym bardziej trafna i spójna będzie odpowiedź. Ważne elementy, które należy uwzględnić w promptcie, to:

- Kontekst sytuacyjny: Określenie konkretnych okoliczności lub scenariusza, w którym model AI ma działać. Przykładowo, czy pytanie dotyczy sytuacji technicznych, biznesowych, czy może edukacyjnych?

- Kontekst audytoryjny: Zdefiniowanie, kto będzie odbiorcą wyników (np. inżynierowie, studenci, menedżerowie), pozwala na dostosowanie odpowiedzi do poziomu wiedzy i potrzeb tej grupy.

- Kontekst domenowy: Dostarczenie tła branżowego lub dziedzinowego, które może pomóc modelowi AI zrozumieć specyfikę zapytania. Na przykład, zapytanie o finanse powinno uwzględniać specyficzne dla tej branży terminy i zagadnienia.

Jakie cechy powinien mieć dobrze zbudowany prompt?

Aby zapewnić spójność i dokładność wyników, prompty muszą być dostosowane do każdego zadania. Unikanie ogólnych poleceń i definiowanie specyfikacji wyjściowych w sposób precyzyjny to podstawa skutecznego prompt engineeringu. Oto kluczowe zasady:

- Definiowanie Specyfikacji Wyjściowych: Ważne jest, aby wyraźnie określić, jaką formę ma przyjąć odpowiedź (np. tekst, JSON, XML) oraz jakie ma mieć ton (np. formalny, konwersacyjny, empatyczny). Dodatkowo warto wskazać długość odpowiedzi.

- Ustalanie Persony i Tonu: Określenie tonu i persony, czyli jak powinien brzmieć model (np. profesjonalnie, przyjacielsko, neutralnie) w kontekście danego zadania. Tego typu wskazówki są niezwykle pomocne, zwłaszcza jeśli odpowiedzi mają być skierowane do konkretnego typu odbiorców.

- Dzielenie Zadań na Kroki: W przypadku bardziej złożonych zadań warto podzielić je na mniejsze, łatwiejsze do zrealizowania etapy. Taki sposób strukturalizacji pomaga utrzymać spójność i poprawia jakość rozumowania modelu.

Jak zarządzać procesem i zapewnić skuteczne wejście?

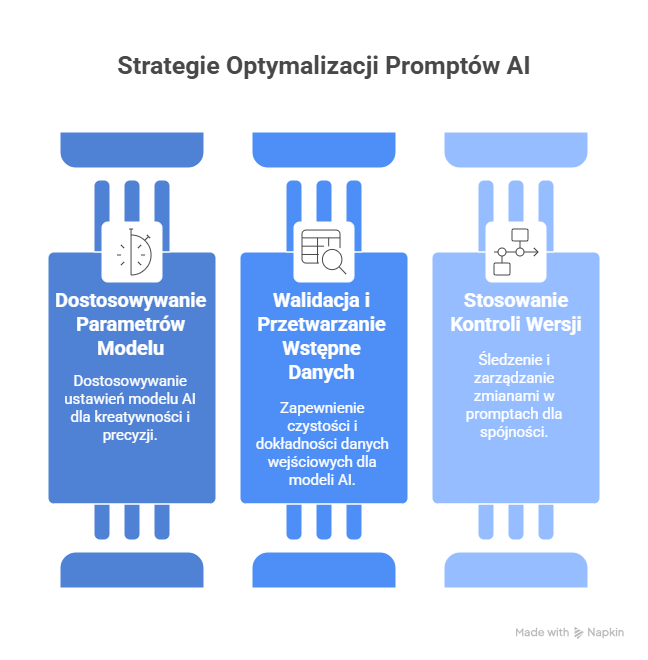

Aby osiągnąć najlepsze wyniki z modelu AI, kluczowe jest dostarczenie odpowiednich danych wejściowych oraz skuteczne zarządzanie procesem. Oto kilka praktyk, które pomogą w tej kwestii:

- Dostosowywanie Parametrów Modelu: Modele AI pozwalają na dostosowanie parametrów, takich jak temperature (dla kreatywności) lub top_p (dla precyzyjności), w zależności od specyfiki zadania. Optymalizacja tych ustawień pomaga uzyskać wyniki, które najlepiej odpowiadają na zapytanie.

- Walidacja i Przetwarzanie Wstępne Danych: Upewnienie się, że dane wejściowe są czyste, ustandaryzowane i wolne od błędów jest fundamentem skutecznej pracy z modelem AI. Błędne lub niekompletne dane mogą prowadzić do niepoprawnych wyników.

- Stosowanie Kontroli Wersji: Śledzenie zmian w promptach i utrzymywanie spójności w ich wersjach to kolejny element, który pozwala na efektywne zarządzanie procesem. Kontrola wersji ułatwia identyfikowanie problemów i wycofywanie niepożądanych zmian.

Zaawansowane Techniki Promptowania w Praktyce

Jak wykorzystać In-Context Learning do lepszego promptowania?

In-Context Learning (ICL) to zaawansowana technika, która pozwala modelowi tymczasowo „uczyć się” z dostarczonych przykładów w czasie rzeczywistym, bez potrzeby dodatkowego treningu. W zależności od liczby przykładów, wyróżniamy trzy główne podejścia do promptowania:

- Zero-Shot Prompting: To podejście polega na podaniu instrukcji lub zapytania bez żadnych przykładów. Model polega wyłącznie na swojej wbudowanej wiedzy i dotychczasowym doświadczeniu.

- One-Shot Prompting: W tym przypadku dostarczamy pojedynczy przykład, który pomaga modelowi zrozumieć kontekst zadania i sposób jego rozwiązania.

- Few-Shot Prompting: To bardziej zaawansowane podejście, w którym dostarczamy dwa lub więcej przykładów. Pomaga to modelowi rozpoznać wzorce i lepiej dopasować odpowiedzi do złożonych zadań, takich jak generowanie listy, kodu czy struktur JSON.

In-Context Learning jest szczególnie pomocne, gdy zależy nam na uzyskaniu strukturalnych wyników lub chcemy, by model dostosował swoje odpowiedzi do konkretnego schematu.

Jak działa technika Chain-of-Thought (CoT) i jak ją wykorzystać?

Chain-of-Thought (CoT) to technika, która zachęca model do „myślenia na głos” i rozwiązywania problemów poprzez generowanie serii pośrednich kroków rozumowania. To szczególnie przydatne w zadaniach wymagających krytycznego myślenia i logiki, jak np. zadania matematyczne czy rozumowanie.

- CoT a Skala Modelu: Zdolność do rozumowania w ramach Chain-of-Thought rozwija się wraz ze skalą modelu. Modele o wystarczająco dużej liczbie parametrów (np. 100B) skutecznie radzą sobie z tą techniką.

- Self-Consistency: Aby poprawić jakość odpowiedzi, model może wygenerować różne ścieżki rozumowania w ramach CoT i wybrać tę, która występuje najczęściej, co zwiększa dokładność i niezawodność wyników.

- Tree-of-Thought (ToT): To rozwinięcie CoT, w którym model eksploruje wiele możliwych rozwiązań i ścieżek rozumowania. Waży ich wady i zalety, a następnie wybiera najlepszą opcję.

Wykorzystanie tych technik pozwala na głębsze rozumowanie modelu i lepsze radzenie sobie z trudniejszymi zadaniami.

Jak poprawić dokładność odpowiedzi za pomocą technik weryfikacji?

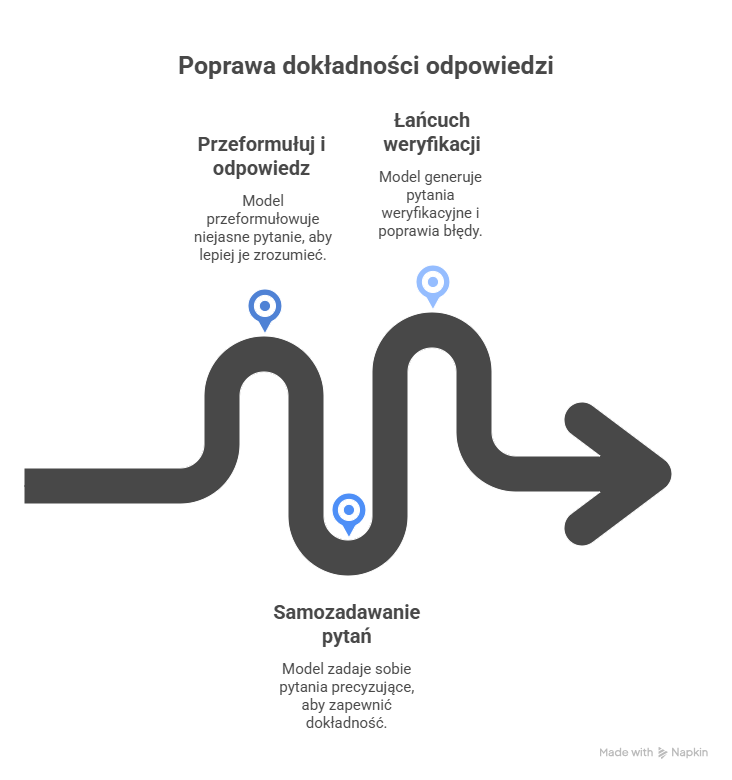

Aby uzyskać precyzyjne i wiarygodne wyniki, techniki weryfikacji i uściślania są kluczowe. Oto najskuteczniejsze z nich:

- Rephrase and Respond (RaR): W tym podejściu model najpierw przeformułowuje i rozwija niejasne pytanie, zanim udzieli odpowiedzi. Dzięki temu może lepiej zrozumieć zapytanie i dostarczyć trafniejszą odpowiedź.

- Self-Ask Prompt: Technika, która zmusza model do spowolnienia i zadawania sobie pytań precyzujących przed sformułowaniem finalnej odpowiedzi. Pomaga to w krytycznym myśleniu i zapewnia, że odpowiedź jest dokładna i dobrze uzasadniona.

- Chain of Verification (CoV): Po udzieleniu wstępnej odpowiedzi, model generuje pytania weryfikacyjne, które pomagają sprawdzić kluczowe fakty. Następnie model poprawia ewentualne błędy i dostarcza ostateczną, zweryfikowaną wersję odpowiedzi.

Techniki te pozwalają zwiększyć niezawodność i trafność odpowiedzi generowanych przez model.

Etyczne Projektowanie Promptów: Odpowiedzialność w Prompt Engineeringu

Jak zapobiegać błędom i dyskryminacji w promptach?

Prompt engineering niesie ze sobą istotne odpowiedzialności etyczne. Modele AI uczą się na danych treningowych, które mogą zawierać uprzedzenia, a te mogą następnie przenikać do generowanych odpowiedzi. Aby uniknąć wzmacniania tych uprzedzeń, należy przestrzegać kilku kluczowych zasad w procesie projektowania promptów:

- Jawne Kryteria Specyfikacji: Aby zapobiec niepożądanym uprzedzeniom (np. faworyzowaniu tradycyjnie męskich imion czy stereotypów płciowych), ważne jest, aby w promptach jasno określić kryteria oceny i ZABRONIĆ uwzględniania czynników demograficznych, takich jak imię, płeć, wiek czy rasa. Przykładowo, w zadaniach rekrutacyjnych powinniśmy skupić się wyłącznie na kwalifikacjach kandydata, a nie na jego płci lub wieku.

- Testowanie Kontrfaktyczne: Techniką, która pomaga w identyfikowaniu potencjalnych uprzedzeń, jest testowanie kontrfaktyczne. Polega ono na wprowadzaniu instrukcji, które sprawdzają, czy wyniki zmieniłyby się, gdyby zmieniono nieistotne czynniki, jak np. płeć lub imię, przy zachowaniu tych samych kwalifikacji. Pomaga to zrozumieć, czy model podejmuje decyzje w sposób obiektywny.

Etyczne projektowanie promptów ma na celu zapewnienie, że AI będzie działać w sposób sprawiedliwy i równy, bez faworyzowania żadnej grupy społecznej.

Jak zapewnić dokładność faktograficzną i transparentność?

Modele AI, mimo że często generują przekonujące odpowiedzi, mogą również popełniać błędy, tworząc tzw. „halucynacje” – fałszywe informacje, które brzmią jak prawda. Jest to szczególnie niebezpieczne, gdy prośba dotyczy tematów wymagających ścisłej precyzji, jak np. definitywne odpowiedzi w nauce czy historia. W celu zapewnienia dokładności i transparentności, warto zastosować następujące zasady:

- Ograniczanie Źródeł: Aby uniknąć rozprzestrzeniania niezweryfikowanych lub niepewnych informacji, należy ustalić jasne granice dla twierdzeń faktycznych. Modele powinny bazować wyłącznie na wiarygodnych i autorytatywnych źródłach, takich jak recenzowane badania naukowe lub organizacje o uznanej wiarygodności.

- Uznawanie Niepewności: W sytuacjach, gdy pewność odpowiedzi jest niska, modele AI powinny jasno odróżniać ustalone fakty od obszarów niepewności. Na przykład, zamiast podać stanowcze stwierdzenie o nieznanym zjawisku, warto używać precyzyjnego języka wskazującego na poziom pewności, jak np. „silny konsensus naukowy” czy „ograniczone dowody sugerują”.

- Przejrzystość Rozumowania: Aby zapewnić większą przejrzystość, warto od modeli wymagać wyjaśnienia procesu myślowego. Instrukcje mogą zachęcać do przedstawienia krok po kroku rozumowania oraz identyfikacji przyjętych założeń, co pozwoli użytkownikom lepiej zrozumieć, jak model doszedł do danej odpowiedzi.

Wprowadzenie takich zasad w procesie projektowania promptów pozwala na generowanie odpowiedzi, które są nie tylko dokładne, ale także rzetelne i transparentne, co zwiększa zaufanie do wyników generowanych przez AI.

Zakończenie

Prompt engineering to dynamicznie rozwijająca się dziedzina, która pełni rolę pomostu między użytkownikami a zaawansowanymi modelami językowymi. Kluczem do sukcesu w tym obszarze jest połączenie kreatywności z techniczną precyzją, co pozwala tworzyć prompty, które są zarówno skuteczne, jak i dokładne. Umiejętność efektywnego projektowania promptów nie tylko usprawnia interakcję z AI, ale również zapewnia, że wyniki będą etyczne i wiarygodne, co jest coraz ważniejsze w kontekście odpowiedzialnego wykorzystania sztucznej inteligencji.

Choć niektórzy twierdzą, że prompt engineering może być zawodem przejściowym, bez wątpienia stanowi on cenną kompetencję, która będzie wyróżniać profesjonalistów w wielu branżach – od programistów po menedżerów. Opanowanie zasad prompt engineeringu wymaga ciągłej praktyki, eksperymentowania i dostosowywania się do szybko zmieniających się technologii. W miarę jak modele AI będą stawały się coraz bardziej zaawansowane, umiejętność tworzenia precyzyjnych, efektywnych i etycznych promptów stanie się kluczową umiejętnością w każdej branży, w której sztuczna inteligencja będzie odgrywać ważną rolę.

Jeśli masz ochotę podzielić się swoimi doświadczeniami z Chat GPT, serdecznie zapraszamy do zadawania pytań i dzielenia się swoimi przemyśleniami w komentarzach do tego wpisu. Razem możemy jeszcze bardziej zgłębić tajniki tej fascynującej technologii.

Najczęściej zadawane pytania (FAQ)

Co to jest prompt engineering?

Prompt engineering to proces tworzenia i optymalizowania zapytań (promptów), które pozwalają uzyskać trafne i precyzyjne odpowiedzi od modeli sztucznej inteligencji. Jest to kluczowa umiejętność w pracy z AI, która umożliwia lepszą interakcję z narzędziami opartymi na dużych modelach językowych.

Jakie umiejętności są potrzebne, aby zostać prompt engineerem?

Aby skutecznie pisać prompty, ważne są umiejętności komunikacyjne, analityczne, techniczne oraz kreatywność. Znajomość działania modeli AI, umiejętność wyrażania myśli w sposób jasny i precyzyjny, a także ciągłe eksperymentowanie z różnymi technikami są kluczowe w tym zawodzie.

Co to jest In-Context Learning w prompt engineeringu?

In-Context Learning (ICL) to technika, która polega na tymczasowym uczeniu modelu AI na podstawie dostarczonych przykładów (tzw. shots). Może to obejmować zero-shot, one-shot lub few-shot prompting, w zależności od liczby przykładów dostarczonych modelowi.

Jakie wyzwania wiążą się z pracą w prompt engineeringu?

Jednym z głównych wyzwań jest praca z niedeterministycznymi modelami AI, które mogą generować różne odpowiedzi na te same prompty. Dodatkowo, ważne jest, aby tworzyć prompty, które są obiektywne i nie zawierają ukrytych uprzedzeń, co wymaga ciągłej analizy i testowania.

Czy prompt engineering jest przyszłościowym zawodem?

Tak, prompt engineering jest umiejętnością, która staje się coraz bardziej pożądana na rynku pracy. Choć niektórzy uważają, że jest to zawód przejściowy, umiejętność efektywnego tworzenia promptów będzie nadal cenną kompetencją w wielu branżach związanych z AI.

Inni przeczytali także:

Czy ChatGPT to przyszłość content marketingu?

102 prompty Chat GPT dla przedsiębiorcy

Czy AI zastąpi SEO?

Jak wykorzystać Chat GPT w marketingu